URL

https://arxiv.org/pdf/2110.07641.pdf

TL;DR

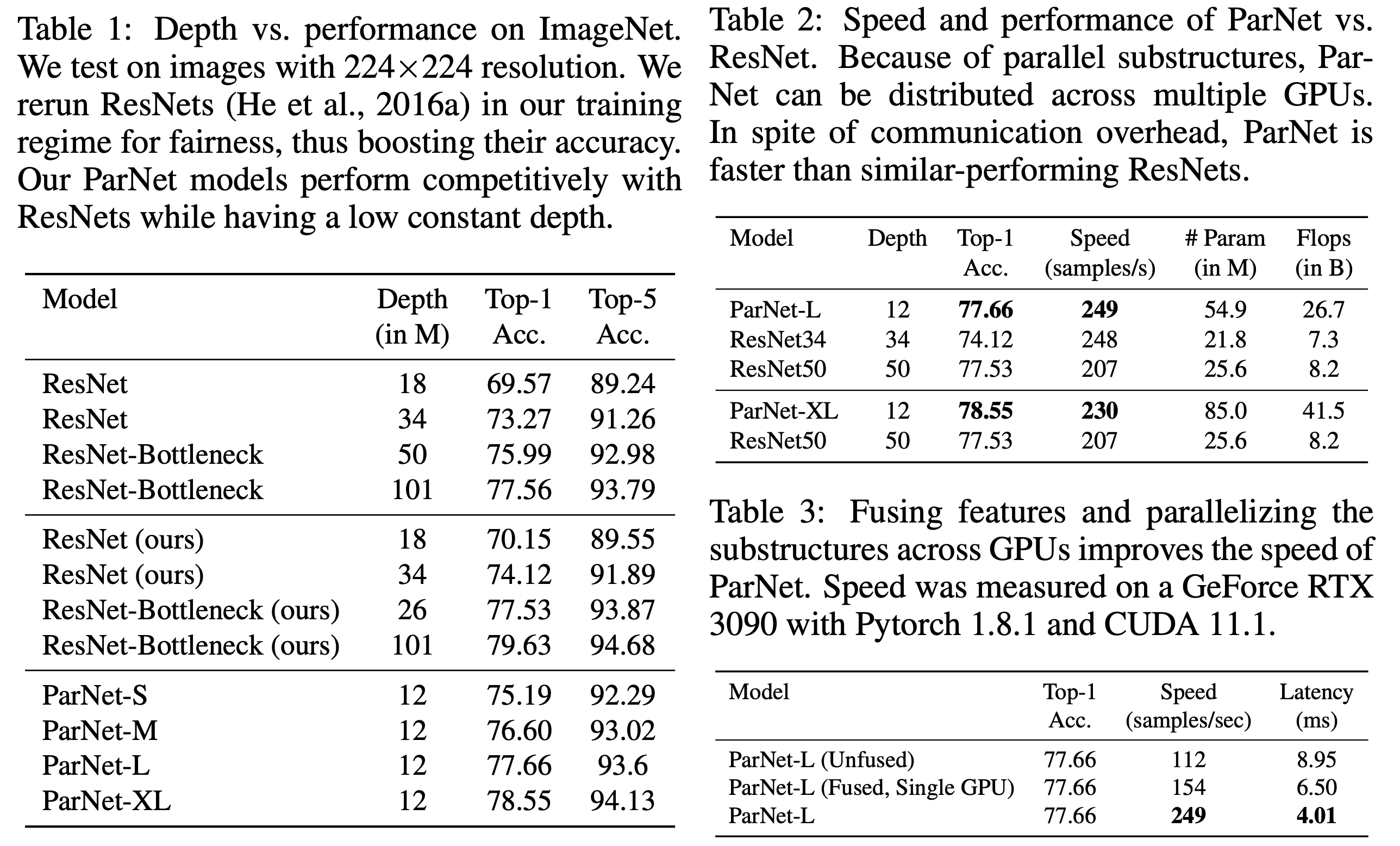

- 本文提出一种浅层神经网络

ParNet,12层深度可以在ImageNet上达到80.72%准确率的效果 - 将网络变宽,因为多个横向

Branch可以并行计算,而纵向深度只能顺序计算 - 将

RepVGG和SENet的结构合并成了RepVGG-SSE结构 ParNet表示parallel substructure network

Algorithm

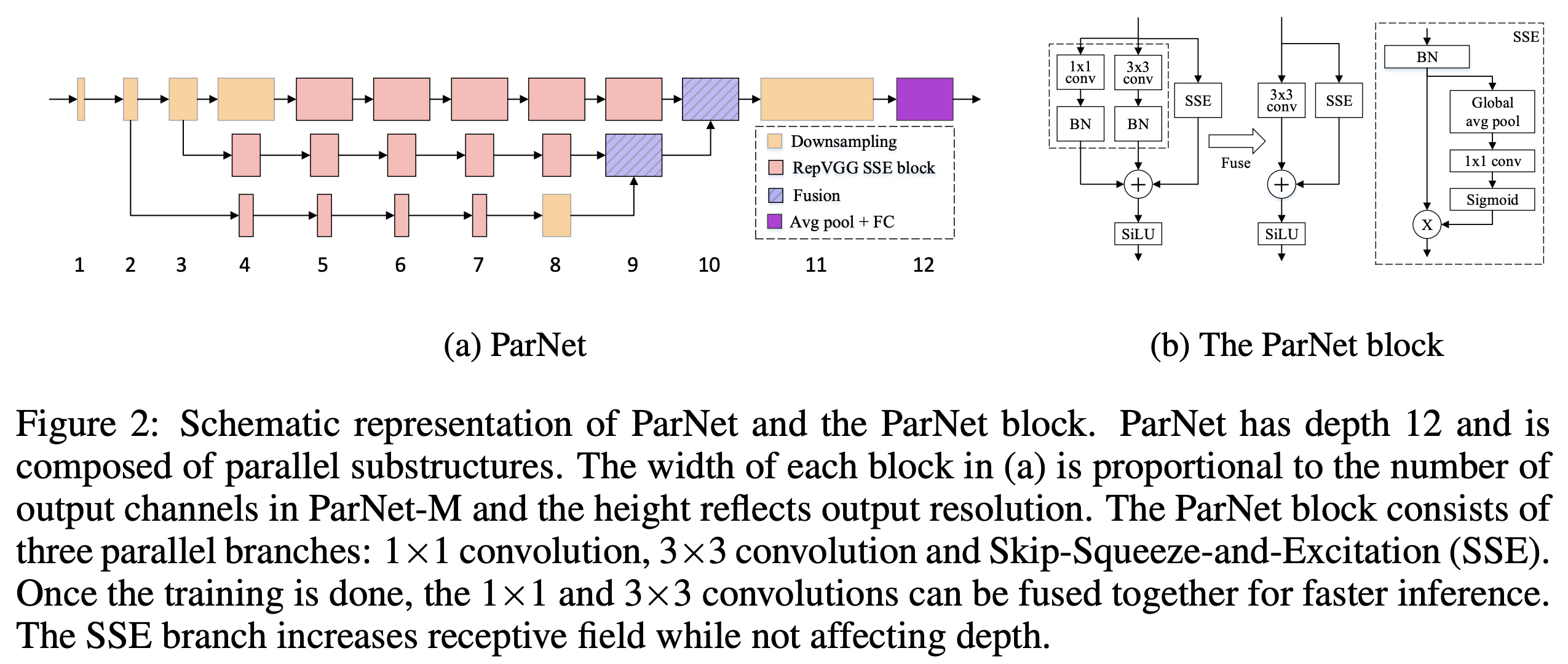

整体结构

- 使用

SENet结构的原因:网络深度过浅,下采样次数太少,只能通过 SE 结构获得全局信息 - 使用

RepVGG结构的原因:结构重参数化白给的涨点,不要白不要 - 使用三个分支的原因:

- 三个分支分别处理不同分辨率级别的

feature,最终fusion - 选 “三” 是效果和速度的

tradeoff

- 三个分支分别处理不同分辨率级别的

- 如何做

model scale:- 传统网络(例如

ResNet)做model scale的方法:- 缩放

H、W:减少下采样次数 - 增加

C:增加卷积核数量 - 增加深度:堆叠

block

- 缩放

ParNet做model scale的方法:- 增大

H、W:减少下采样次数 - 增加

C:增加卷积核数量 - 增加

Stream:增加横向Branch数量

- 增大

- 传统网络(例如

SSE是指Skip-Squeeze-and-Excitation:为降低网络层数,将 SE 结构中 GAP 后的 feature 做一层 Conv 而不是两层 MLP- 本网络除了

SSE结构之外,没有跳边连接

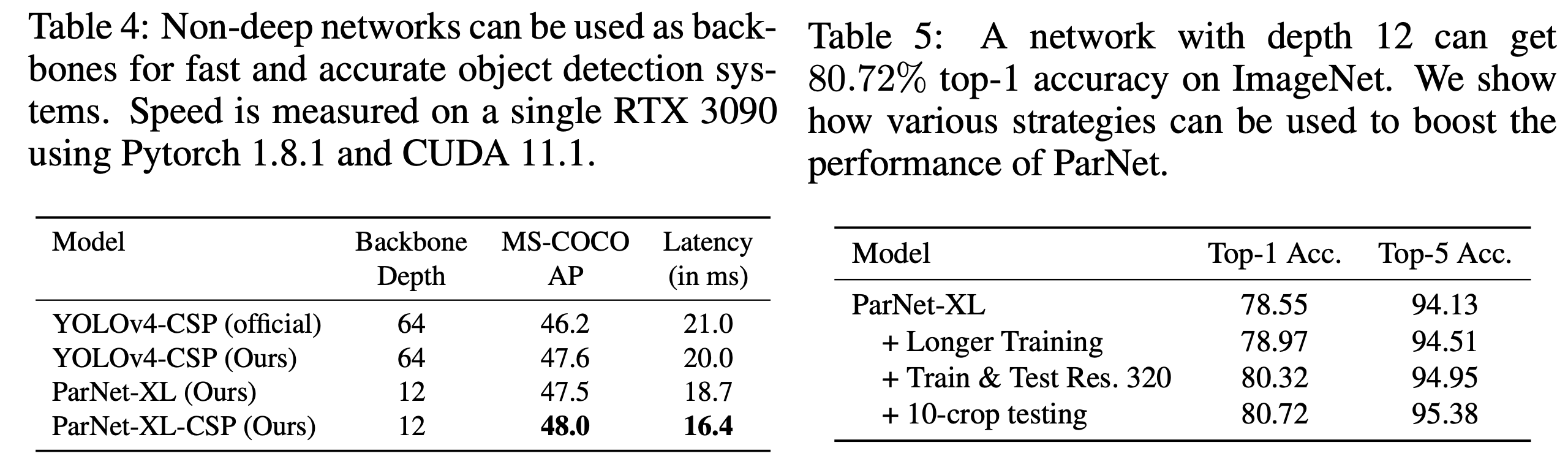

效果

这个图有点不公平,因为横坐标表示层数而不是参数量

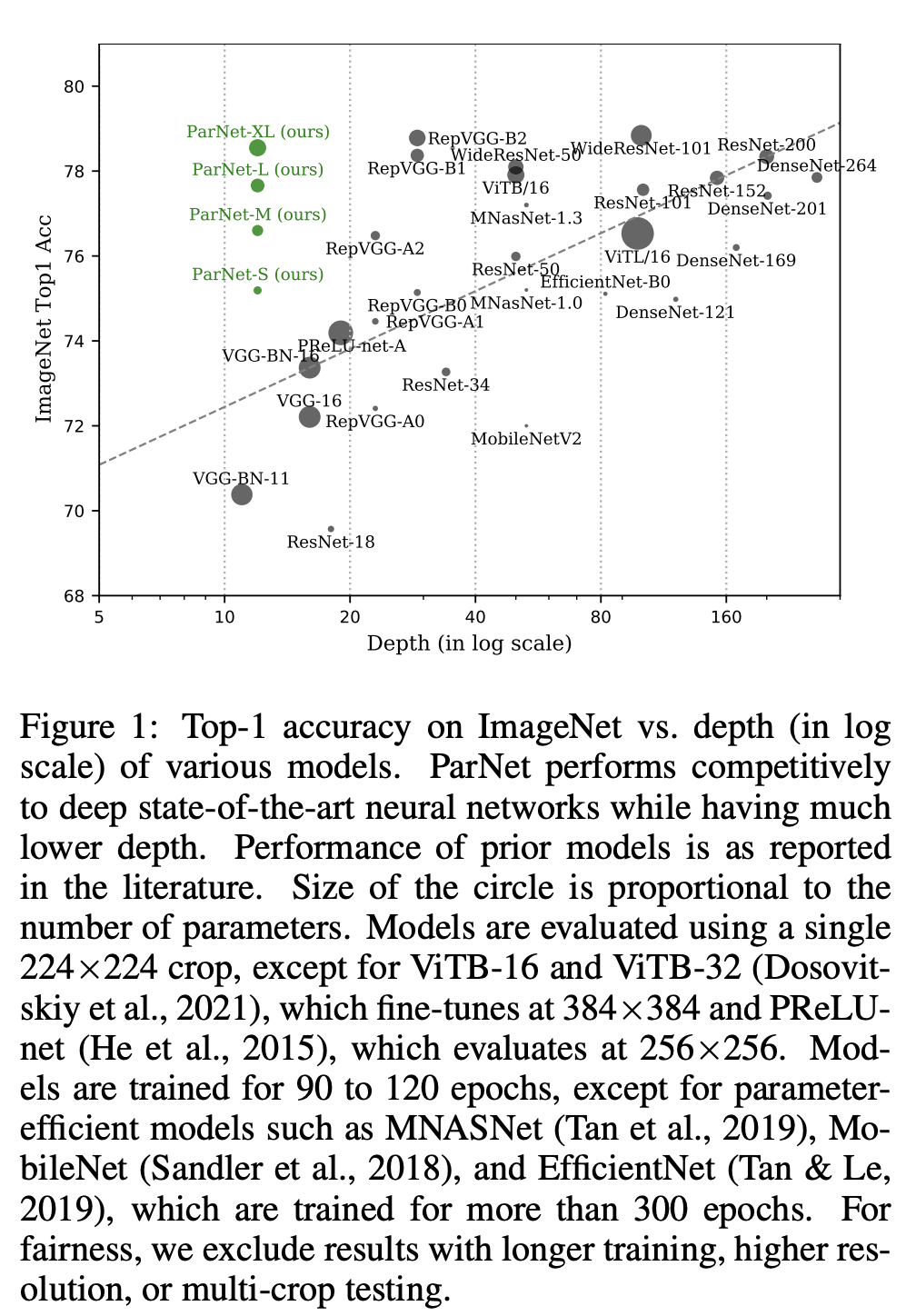

- 和

ResNet对比

- 对下游任务也有涨点加速的作用