URL

TL;DR

- 本文提出的

prompt tuning和prefix tuning非常相似,是一种通过给不同任务输入前添加不同前缀,同时冻结原预训练模型参数的微调方式 - 和

prefix tuning区别主要在前缀词向量的设置和初始化方式方面

Algorithm

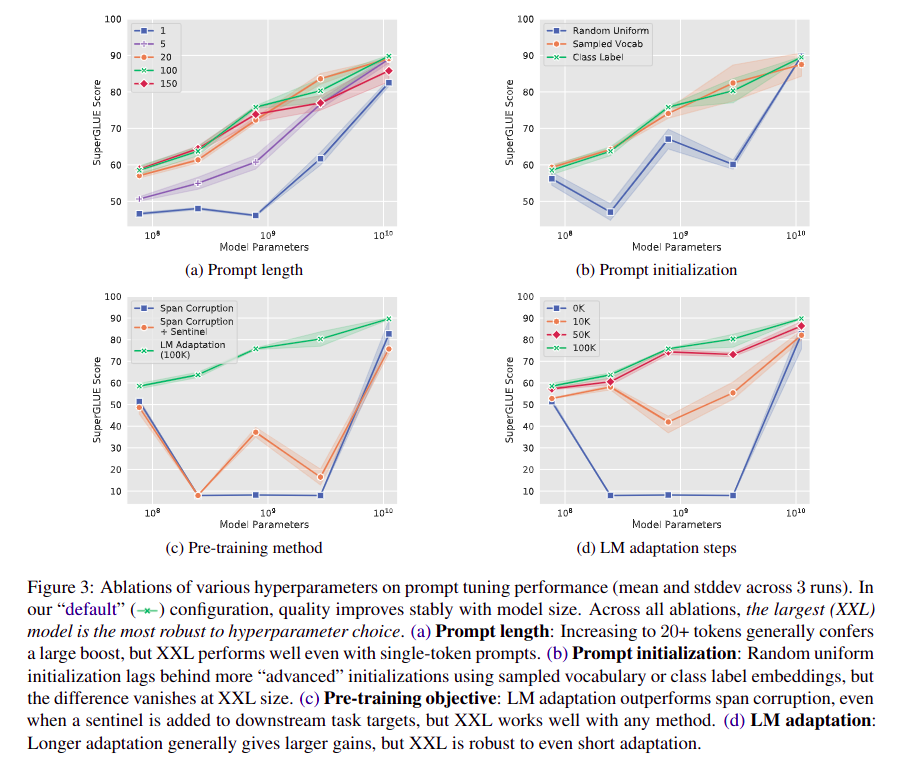

Prompt tuning 的前缀词向量长度应该设置多少?

- 作者实验了

{1, 5, 20, 100, 150}等长度的前缀长度,结论是20最合适,超过20收益可忽略

Prompt tuning 的前缀初始化方式

- 作者实验了三种前缀初始化方式:

- 随机初始化(和

prefix tuning一致) - 从词表中随机选择常见词初始化

- 用自然语言描述任务,并将其根据词表转化为词向量

- 随机初始化(和

- 实验结论是:第三种方式最优

其他部分

- 我没看出来和

prefix tuning有任何不同,甚至本文对prefix tuning的理解都是错的

Thought

- 我认为这篇论文在

prefix tuning的基础上改动较小,比较水