0%

URL

TL;DR

- 人类通过语言推理(分解目标、调整计划)与行动(获取外部信息)的协同机制高效完成任务(如烹饪时动态调整步骤)。

- 受到人类智能启发,本文提出一种

Reasoning 和 Acting 相结合的框架,称为 ReAct,这种新的推理范式可以使语言模型在复杂任务中表现更好。

- 主要优势包括:

- 事实性:减少模型幻觉(虚构信息)。

- 决策鲁棒性:增强模型在复杂环境中的泛化能力。

- 可解释性:人类可以追踪模型的推理轨迹。

Algorithm

ReAct 框架

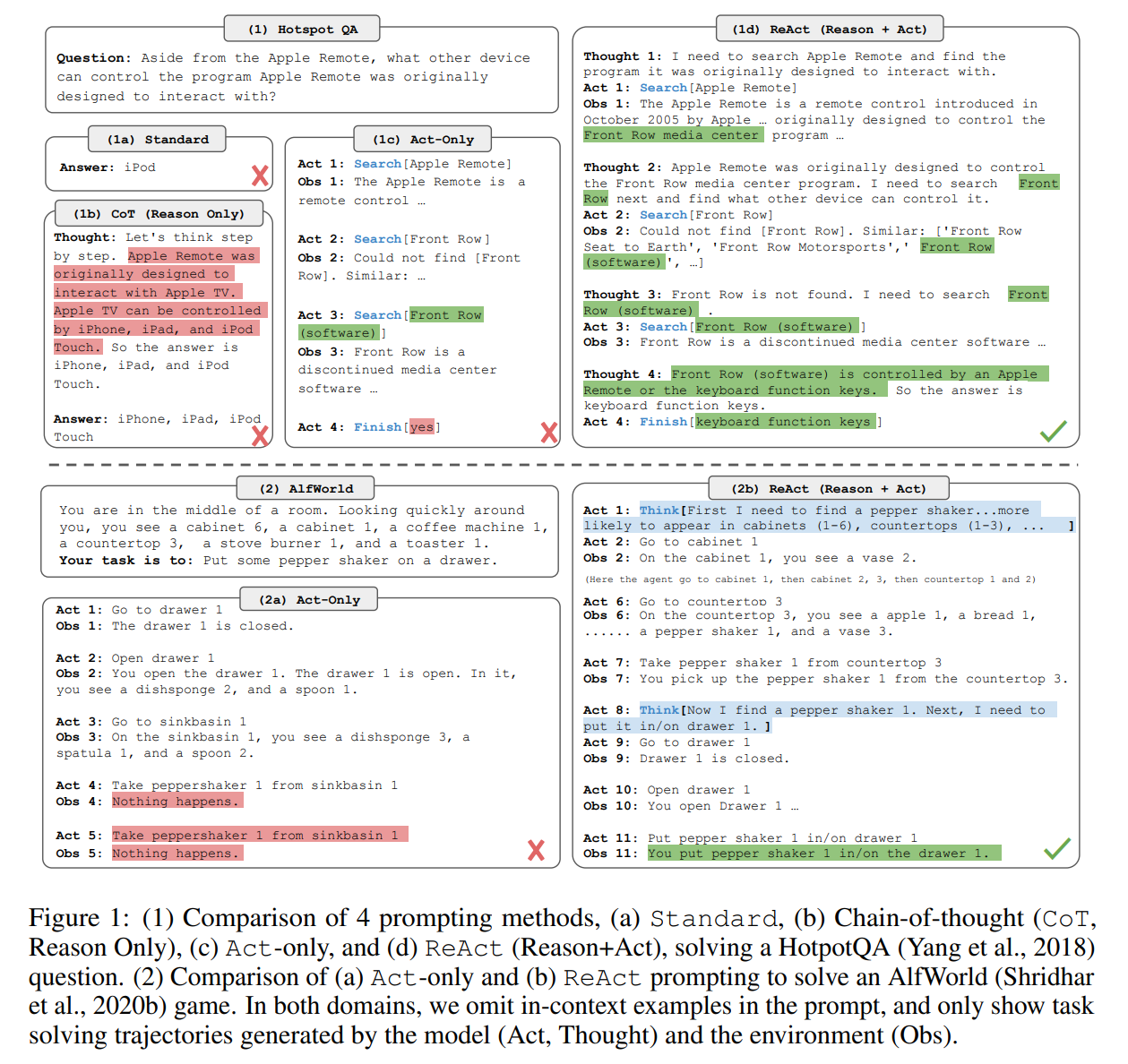

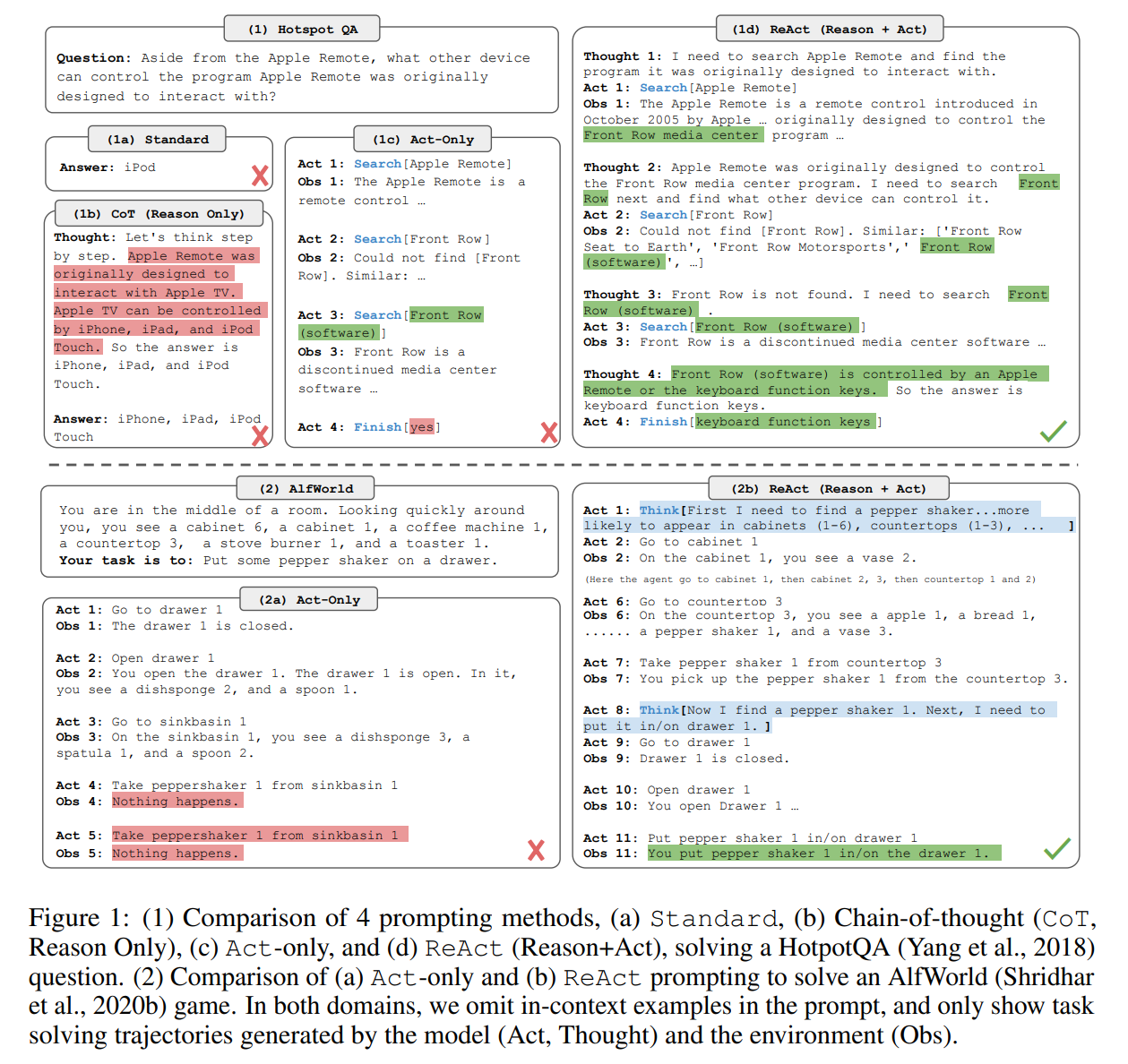

- 纯推理模型(如

Chain-of-Thought):易产生事实幻觉(如虚构信息)和错误传播(如算术推理错误),缺乏实时环境交互能力(图 1b)。

- 纯行动模型(如

WebGPT):缺乏高层规划能力,难以处理多步决策(图1c)。

ReAct 模型:交替进行推理和行动,能够在复杂任务中表现更好(图 1d)。

核心贡献

- 首提协同框架:统一推理与行动,解决静态推理与无规划行动的缺陷。

- 实践价值:

- 提升模型事实性(减少幻觉)与决策鲁棒性(复杂环境泛化)。

- 增强可解释性:人类可追踪推理轨迹。

Thoughts

- 论文提出的算法一眼开门,非常符合直觉,从哲学角度讲,一个事物的超集一般都优于其本身,因为最差的情况就是超集退化为本身(因此常见的一个情况是:新的论文称一篇老的论文是其某个参数设置下的一个特例)。

- 这些所有的

Reasoning 和 Acting 等 Agent 功能,都建立在大模型超长上下文的基础上,因此模型支持超长上下文长度是模型是否具有高级智能潜质的先决条件(至少现有范式是这样)。