URL

TL;DR

- 本文提出一种类似

GPT-4的图文多模态模型Large Language and Vision Assistant (LLaVA),基于开源的CLIP和LLaMA分别作为图文编码器,因此LLaVA也完全开源

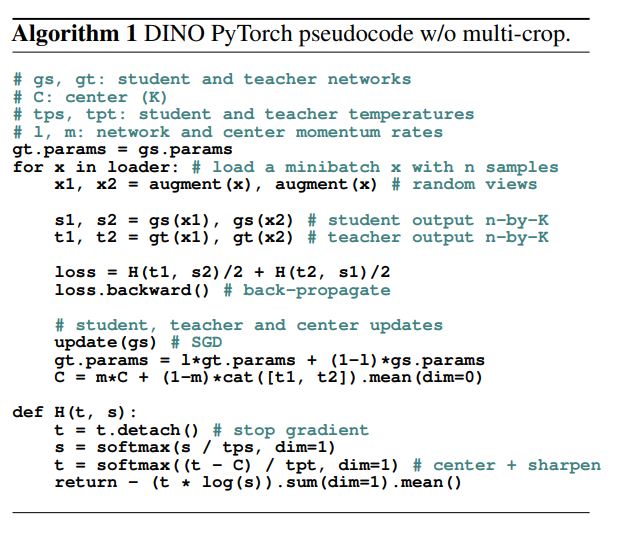

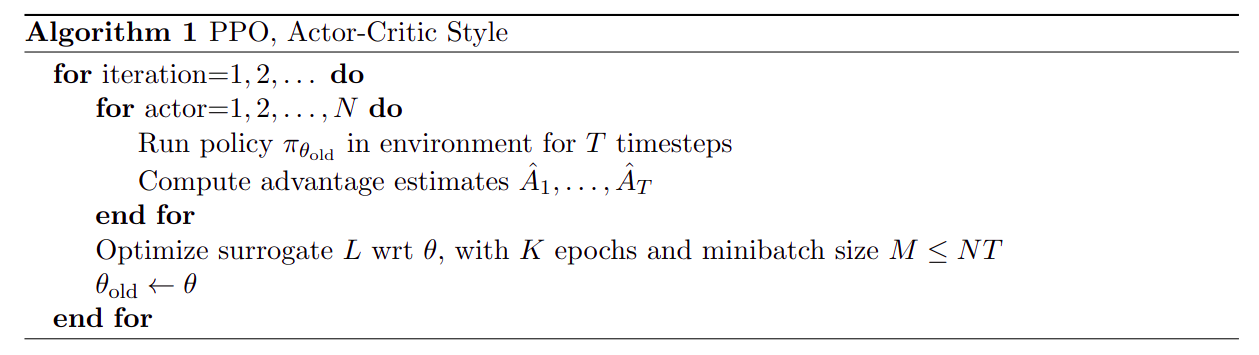

Algorithm

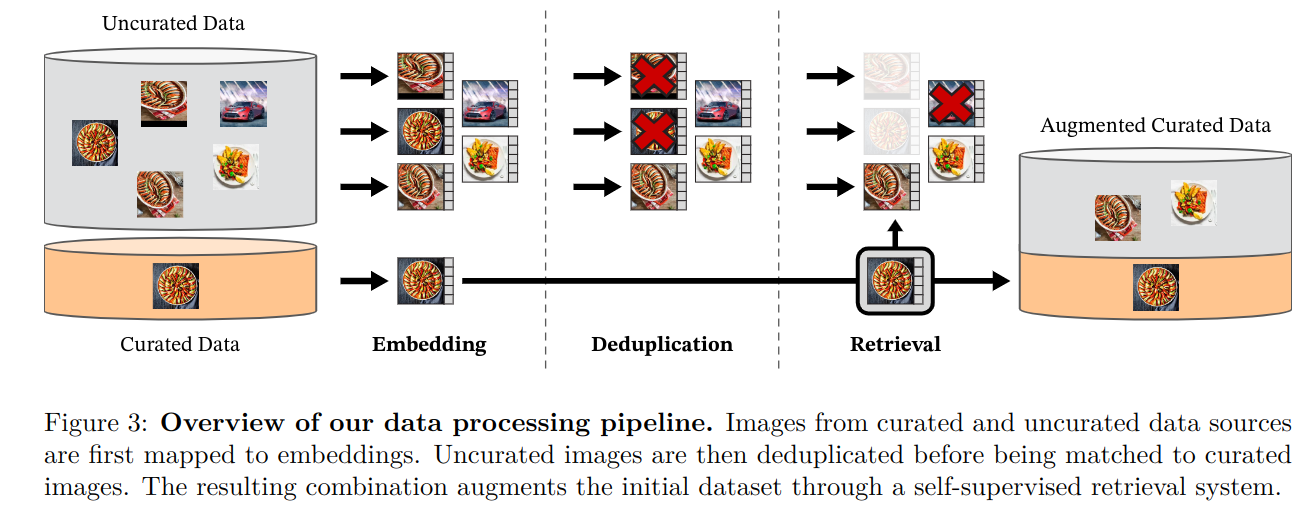

多模态指令遵循数据生成

- 已有:图形——文本对数据集

- 需要:图文指令遵循数据集,格式为:

- 图片:原始图片

- 问题:由

GPT-4生成,输入原始 “图片-文本” 给GPT-4,让GPT-4就这些信息提问 - 答案:同上,让

GPT-4回答自己提出的问题

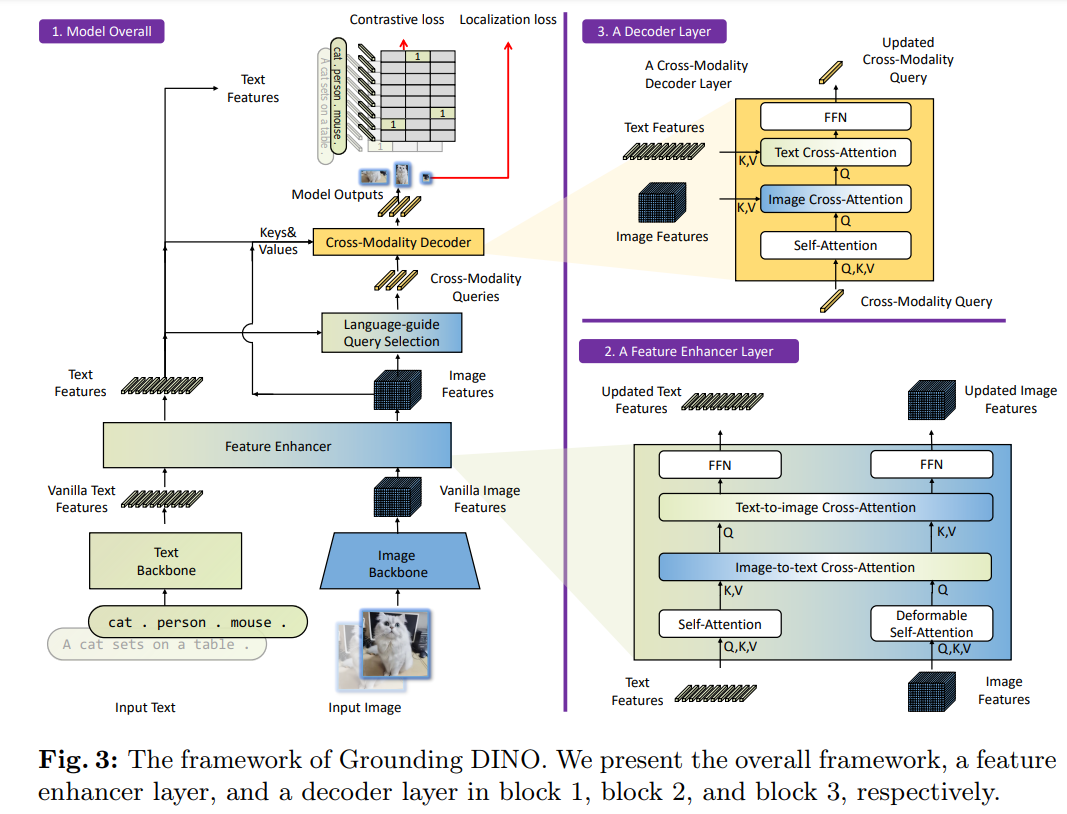

模型结构

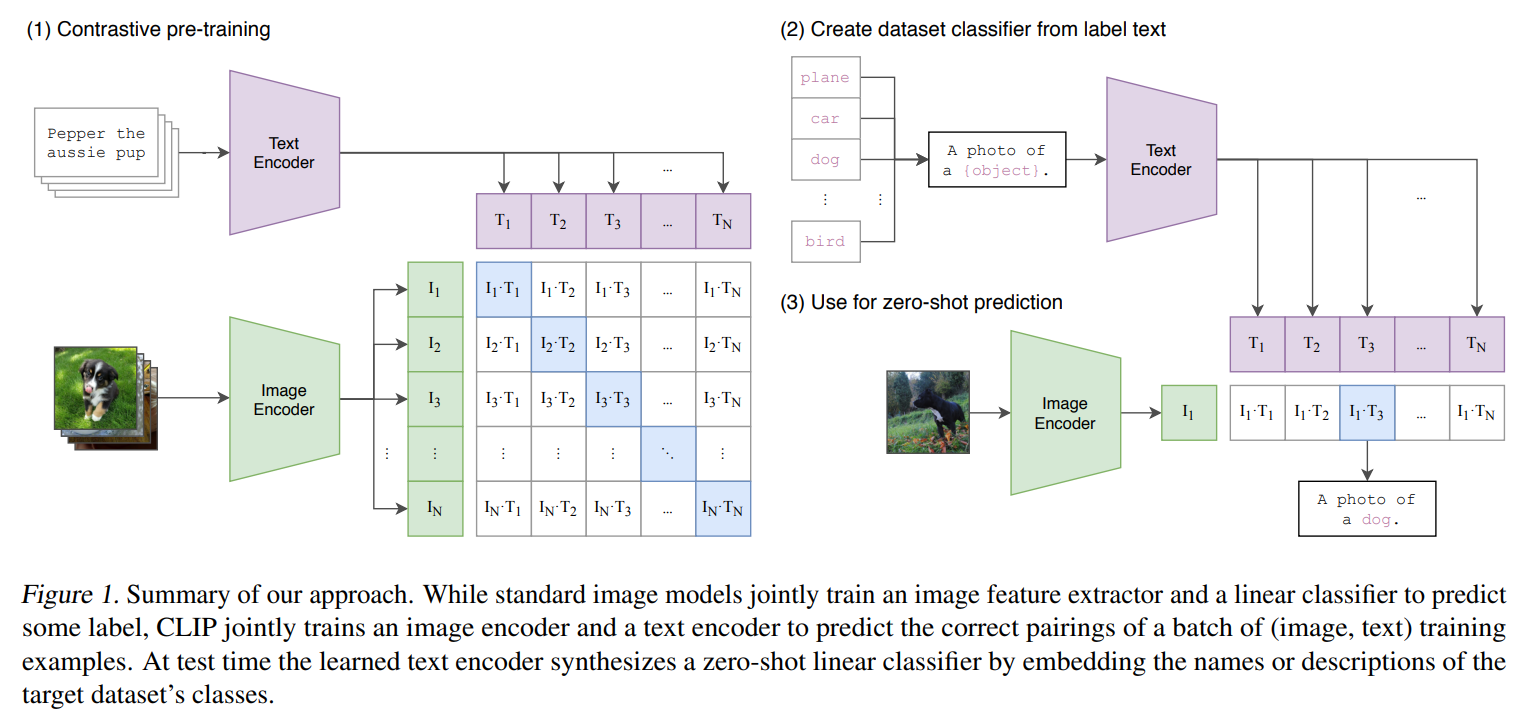

- 图像模型:

CLIP ViT-L/14已做过图像文本对齐的预训练图像编码器模型 - 大语言模型:

LLaMA预训练模型 - 连接层:简单的线性映射层

如何训练和微调

训练

- 冻结图像编码模型

- 冻结

LLM模型 - 训练连接层

微调

- 冻结图像编码模型

- 训练

LLM模型 - 训练连接层

graph TD;

A([视觉编码器]) --> B([连接层])

B --> C([LLaMA语言模型])

D[语言指令(例如:“请根据这张图片生成一个详细的描述”)] --> C

C --> E[文本响应]

F[图像] --> A

G[系统消息(例如:对话历史记录)] --> C

Thought

- 简单直接,来自开源,也回馈开源,很棒!